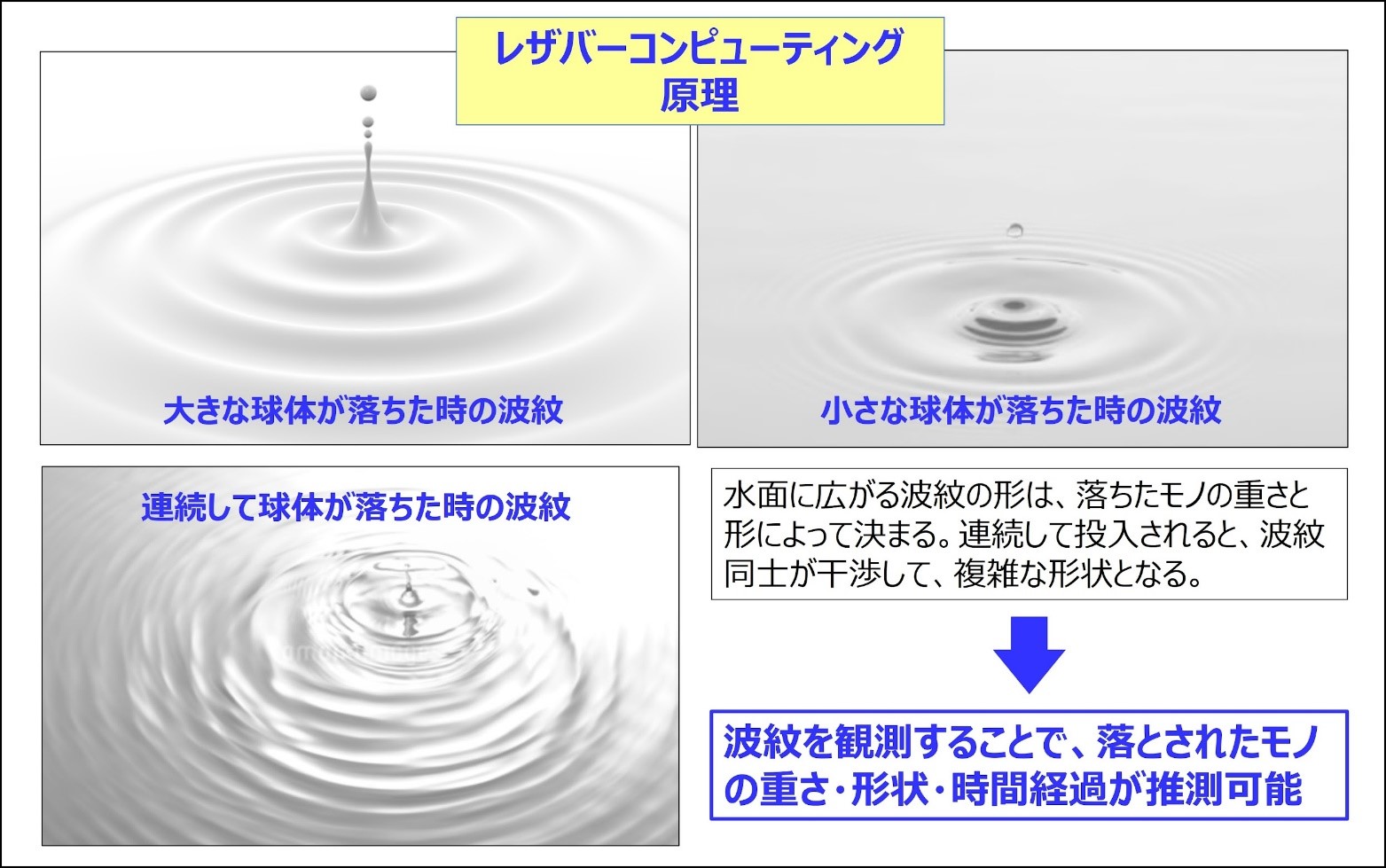

私も最近までまったく知らなかったのですが、国の産総研やNEDOが積極的に研究支援しているようです。それでも、今までほとんど注目されていませんでしたね。とにかく、レザバーコンピューティング(Reservoir computing)、研究機関によってはリザバーコンピューティングと言っていますが、ユニークなAI技術であることは確かです。概念図を示します。

※図版:筆者作成「レザバーコンピューティングの原理」

レザバーとは貯水池とかため池の意味ですが、そこに石を投げ入れると波紋が生じますね。その水面に広がっていく波紋の形状や大きさは、投げた石の形や重さで変わります。続けて複数の石を水面に投げ入れると、複数の波紋が干渉して複雑な波紋となります。逆に、その波紋を観察すれば、どのような石が投げ込まれたかを推測することが可能です

まぁやってみなければわからないけど、実験を繰り返せば推測ができそうな気もします。

波紋は、石の特徴や時間経過を誇張して表現したものと考えられます。したがって、波紋の時系列データをニューラルネットワークに投入して学習し、判断させるのが、レザバーコンピュータなのです。

時系列データを処理するAI技術なら、以前説明があったRNNですよね。

その通りです。レザバーコンピューティングはRNNの一種です。ただRNNほど単純なネットワークではありません。

※図版:筆者作成「レザバーコンピュータによる音声認識の概念図」

これはレザバーコンピュータの概念図です。例として時系列データである音声データを入力して音声認識をする仕組みの図解です。RNNは中間層が1つしかありませんが、レザバー層はネットワークが若干複雑な程度です。しかしネットワークは固定で、学習は出力層になります。ディープラーニングのようにネットワークが数千層とか数百万層などありません。このレザバーコンピュータは、1990年頃から研究されていたのですが、ディープラーニングと比較して圧倒的に精度が低いということで見放されていたのです。

そんな単純なニューラルネットワークで、なにができるというのですか?

シンプルな構造がレザバーコンピュータの特徴なのですが、最近になって日本のQuantum Core社により、時系列データを高速・低消費電力・低コストで処理ができるようになったのです。少量データかつリアルタイム学習でも精度の高い判定ができる新しいRNN技術を発表し、一躍注目を浴びたのです。(註)Quantum Core社の発表によると、心電図での疾患判定が精度93%、音声での話者特定が精度99%、音での作業状態特定が精度94%などの事例が多数あるようです。

それは凄いな。やっぱり流行りのLLMは競争が激しいレッドオーシャンの世界だからダメで、他の研究者が眼を付けないブルーオーシャンの技術を深堀することで金脈が発見できるんだ。貧乏な日本には、やっぱり“安い・速い・上手い”の戦略だな。

ビッグテックは、とにかく金脈らしきものを見つけたら、一気呵成に莫大な資金と人材を投入することで、後続を振り切ってきました。日本で実用化が始まったレザバーコンピュータは、IPA(情報処理推進機構)の未踏ターゲット事業に選定差されていますが、多少の人材支援だけで資金援助はないようです。

まだ欧米では注目されていない技術ですよね。もし大きな成果が出たらビッグテックが狙ってくるかもしれませんよ。

それこそ世界制覇を狙えるAGIのような技術と違って、今のところレザバーコンピュータはニッチな市場向けだと思われています。しかしエッジAIには最適なので、SLMが想定している市場の多くを担えると私は考えています。というのも、あの程度のニューラルネットワークは、1チップコンピュータでも処理できます。つまりSLMを稼働させるためのコンピュータより、桁違いに省電力・低価格・コンパクトで実現できます。つまり、あらゆる産業機器や産業用ロボットに最適なのです。それこそ前回話したステルスAIそのものなので、いつのまにか使われていくはずです。

そうなんですか。もしかすると、安くても大量に出るので巨大マーケットになるかもしれないのか。

そこを日本政府も期待しているので、レザバーコンピュータに使えるエッジAIチップの研究に、かなりの資金を投入して支援しています。(註)

日本政府は、ハードウェアにしか資金援助しないようですね。

では冒頭で言及したOpenAIの革新的AI「o1」の説明に移ります。

いつも画期的なAIが発表されていますが、今度はどこが革新的なんですか?

今回OpenAIが9月に発表したAIの性能には、世界中のAI研究者が本当に驚いています。AIの名称が従来のGPTシリーズではなくOpenAI Model Number Oneの略称「o1」なのは、LLMをベースにスケーリング則に従って巨大化してきたGPTと、異なるアルゴリズムのAIだからです。

え!そうなんですか?OpenAIは莫大な資金調達をして、AI専用のデータセンターまで造って、ひたすら巨大なLLMでAGIまで突き進むと、先生は言ってましたよ。

確かに言いました。OpenAIが「Q*」とか「Strawberry」と呼ばれている新型AIを研究している、という噂が流れていましたが、GPT5のようなLLMの延長線上にあるとばかり思っていました。それが覆されたので驚いたのです。

それで、何がどう凄いAIなんですか?

9月の発表はPreview版でしたが、12月には正式なo1シリーズとして、o1 mini、o1、o1 pro modeというモデルを公開しました。(註)o1シリーズは、GPT-4oよりも複雑なタスクの推論ができ、科学や数学とプログラムのコーディング、計画能力で圧倒的な性能向上を達成しています。主要な性能は以下になります。

・物理学、化学、生物学において、博士が対象となるベンチマークタスク(GPQA Diamond)で正答率78.0%で、各々の分野での博士課程の学生正答率69.7%を超える成績を達成。

・国際数学オリンピック(IMO)の予選試験で、GPT-4oは正答率13%だったが、83.3%を記録。

・コーディング能力では、競技プロラミングCodeforcesスコア89パーセンタイルで、参加者の上位11%に入る水準だった。

確かに凄い性能ですね。じゃぁLLMの最新版GPT-4oの性能を凌駕したんですか?

そうでもありません。いわゆるSTEM分野、つまり数学や科学技術分野では圧倒していますが、言語処理の分野に関しては、まだGPT-4oの方が優れているという人間の評価があります。ただ、このようなAI性能に関しては日々バージョンアップされていくので、GPT-5やo3が登場するとどうなるかは分かりませんが。

では、OpenAIはGPTシリーズの開発を止めて、「o1」シリーズに全面移行するわけではないんですね?

そうだと思います。今までGPTに莫大な投資をしてきているので、投資回収していく必要もありますし。

それにしても、OpenAIは2つの異なるAIモデルの研究開発をする必要があるのに、たしか社員を大幅削減してましたね。

アメリカでの報道によると、主要な役員が辞任したり大規模な社員削減を進めているようです。本当ことは分かりませんが、その原因は2つ考えられます。一つは軍事産業に参入することが明確になったことです。以前の講義で指摘しましたが、AGIにまでなるとAIテクノロジーは世界のミリタリーバランスを揺るがすほどの軍事技術になるからです。AIテクノロジーは、中国とアメリカがほぼ同水準にあり、中国共産党は当然のようにAI機能を兵器に搭載しているので、対抗上アメリカもOpenAIを支援しています。このOpenAIの方針変更に役員やエンジニアが反発していることは容易に想像がつきます。

OpenAIは当初、軍事産業には加担しないと明記していましたからね。

もう一つは、自社が開発しているAIの能力が、社員の能力を次第に上回ってきたからだと思っています。先ほど示した「o1」の能力があれば、プログラマーレベルの業務なら代替可能なはずです。公開しているAIは、まず社内利用してデバックなどをした結果なので、ユーザー利用可能なレベルなら当然自社で利用しているはずです。プログラミングの生産性が非常に向上したはずなので、社員を削減しているのかもしれません。私の想像にすぎませんが。

まぁ、あり得ますね。ということは、OpenAIの研究者たちは自分の首を切るためのギロチンを作っていたようなものか。

実際に、「o1」シリーズを開発している研究者がインタビューで、多くの能力は私よりAIの方が上回ってしまったが、小説を書くなどの能力が低いので、私にはまだ仕事が残っている、と言っていました。長くなったので、この続きは次回にします。

・レザバーコンピュータはLLMとは原理が異なり、日本が開発を先導している超小型で低価格の時系列処理AIである。

・しかも少量データをリアルタイムで学習すれば利用できるため、エッジコンピュータに最適で、今から大きな市場が見込こめる可能性がある。

・OpenAIが公開した「o1モデル」は、LLMとは原理が異なる画期的な推論AIで、STEM分野で博士号クラスの成績とトップレベルのコーディング能力を備えている。

著者:谷田部卓

AIセミナー講師、著述業、CGイラストレーターなど、主な著書に、MdN社「アフターコロナのITソリューション」「これからのAIビジネス」、日経メディカル「医療AI概論」他、美術展の入賞実績もある。

(TEXT:谷田部卓 編集:藤冨啓之)

メルマガ登録をしていただくと、記事やイベントなどの最新情報をお届けいたします。

30秒で理解!インフォグラフィックや動画で解説!フォローして『1日1記事』インプットしよう!

前回の講座の最後の方で、多様化するSLMとしてエッジAIの話をしました。今回は11月に開催された幕張の展示会で、また新しいエッジAIを見つけてきたのでその話をしましょう。

OpenAIが12月になったら、クリスマスまで毎日1件新しいことを発表するなんて言ってますが、そっちはいいんですか?

今までも毎週のように新型AIが発表されていますが、毎日となるとさすがに追いきれませんね。それでも9月に公開されたOpenAIの”o1”は、無視できないレベルの革新的AIです。しかしこの説明をしだすと、かなり長くなるので、日本にとって画期的と言える新型AIが登場したので、そちらを先に説明します。

へ~、それはOpenAIのLLMより凄いAIなんですか?でも、そんな新型AIを日本がいつのまにか開発していたなんて聞いたこともないですよ