①知識を保持している、LLMの重み行列にある主成分を特定することで、膨大で複雑な知識を、より小さく、意味のある、独立した断片(数学、言語理解などの構成要素)に分解する。

②分解された要素のうち、重要度の高い要素(特異値)だけを調整。

③調整後の要素を、再び組み合わせて新しい重み行列を再構成する。

一般的なAIモデルは、数学の問題を解いたり、翻訳したりと、様々な種類のタスクに対応しなければなりません。しかし、すべてのタスクに同じように対応するのは、効率的ではありません。そこで自己適応型 LLMは、状況に応じて最適な方法でAIモデルを調整する「適応戦略」を導入しました。つまりタスクの性質や難易度に応じて、最適な対応方法を選択しています。

①プロンプトベース適応:AIへのプロンプトを分析し、数学の問題なのか要約なのかなど、タスクの種類を判断、それに適した調整を行う。この方法は計算効率が高く、素早い対応が可能。

②分類エキスパート:タスクの種類を識別するための高度なモジュールを使用し、プロンプトベース適応よりも、さらに正確にタスクの種類を見分けて、より適切な調整をする。この場合多少計算量が増加となる。

③Few-shot適応:少数の例を使って学習する方法。新しいタイプのタスクに柔軟に対応できるが、最も多くの計算量を要する。

この3つ方法を使い分けることで、自己適応型 LLMは様々な状況に応じて最適な方法に適応させます。簡単なタスクには軽量な方法を、複雑なタスクには高度な方法を使うことで、効率的かつ効果的な対応が可能となります。

なるほど、でも理屈は分かりますが、「最適な方法」なんてすぐに見つけられるんですかね。実際の結果はどうですか?

研究チームは、自己適応型 LLM の効果を、MetaのLLAMA3-8BやフランスのMISTRAL-7Bなどの、小型で高性能なLLMで検証しています。その結果、従来手法と比較して、最大16%の性能向上を達成しています。特筆すべきは、全パラメータの0.25%以下という極めて少ない調整で、完全な微調整の96%の性能を実現しています。特に数学的問題解決能力において、顕著な向上が見られています。

あれ?ちょっと待ってください。自己適応型 LLMとは、Sakana AI独自のLLMを開発したんじゃないんだ。

そうですよ。分かりづらかったかもしれませんが、LLMを少ないリソースで効率よくダイナミックにチューニングする方法です。潤沢な資金のあるビッグテックは、あらゆるタスクに万能なAGI(汎用人工知能)を目指しています。しかし常にリソースが足りないオープンソースのLLMにとって、多様なタスクに対して少ないリソースで動的に対応できる、画期的な方法なのです。

なるほど、オープンソース勢のSakana AIならではの成果だったのか。

では次に、2025年5月に発表された「時間を使って考えるAI・Continuous Thought Machine(継続思考マシン:CTM)」です。

しかし、いつも聞いたこともない名前のAIですね。

前例がないユニークなAIなので、まったく新しい名前を付けるしかないからです。このCTMは、先ほどの実用的なTransformer²とは違って、まだ研究の段階ですが、一言で言うと、生物の脳に“より近い”仕組みのAIモデルです。

現在のAIは全部、脳をモデルにしたNNですよ。

もちろんそうなのですが、このCTMが脳神経細胞ニューロンを真似た、今のNNと、決定的に違う点があります。それはニューロンの強さだけなく、シナプスがスパイク(発火)するタイミングまで学習に取り込んだ点にあります。人工ニューロンのモデル(NN)は、1980年代に考案されましたが、今までスパイクの強さしか考慮していませんでした。実際の脳は時間とともに進化する複雑な神経ダイナミクスを示しており、スパイクのタイミングにも機能があることが、研究で判明しています。つまり現在のNNは、「いつ」ニューロンが活動するのか、というタイミング情報が抜け落ちているのです。これは巨大化していくAIのNNを、単純化して計算を効率化したいという理由もあるのですが、そこにSakana AIが着目しました。そして脳活動のタイミング情報を利用した、まったく新しいニューロンを考えたのです。

それは凄いな。ということは40年以上変わらずに利用されている、ノーベル物理学賞の対象となったNNのモデルを、根本から直そうとしているのか。でも、どうやって?まさか生きて活動している脳細胞が、盛んにスパイクしている状態をリアルタイムに観察したとか。

以前も講義で話しましたが、ノーベル賞を受賞したヒントン氏とホップフィールド氏よりも、10年早い1970年代に当時のNHK技研にいた甘利俊一氏が、脳神経細胞のコンピュータモデルを提唱しています。このモデルの研究のため、生きた猫の脳を観察していましたが、サルくんはこの話のことを言っているのですね。そうではありません。

ですよね。NHK技研の裏庭には、猫を弔った猫塚があるとかいう話を覚えていたもんで。

Sakana AIは生物学が専門ではないので、脳を観察するのではなく、仮説をたててプログラミングして検証する手法のようです。具体的には、個々のニューロンを自身の過去の活動履歴にアクセスさせ、現在の状態だけでなく履歴情報を使って次の出力を計算するよう学習させます。さらにニューロン間の活動のタイミング情報を利用して、互いに同期した活動を生み出すことでタスクを解くように学習させました。これにより、現在のAIモデルよりもはるかに豊かなニューロン活動パターンが生まれ、この多様性が、幅広いタスクを解く能力を引き出すことができた、と主張しています。

漠然としか理解できない説明ですね。でも、過去の活動履歴を利用するNNには、たしか昔からある時系列処理のRNNがありましたよね。最近は聞かないけど。

よく覚えていましたね。たしかに古典的なNNであるRNNは、入力された音声のような時系列データをNNに入れ、その出力を再度入力側に入れることで時系列パターンを覚え、出力される時系列データが予測できる機能があります。これを再帰性といいますが、反復処理と時間経過に伴う情報の蓄積を可能にするので、今の生成AIの主流アーキテクチャであるトランスフォーマ(Transformer)でも、この再帰は重要な機能のひとつになっています。

じゃあ、今とおなじじゃないですか。

いいえ、履歴だけではなくタイミング情報、つまり時間の概念をNNに組み込んだのです。

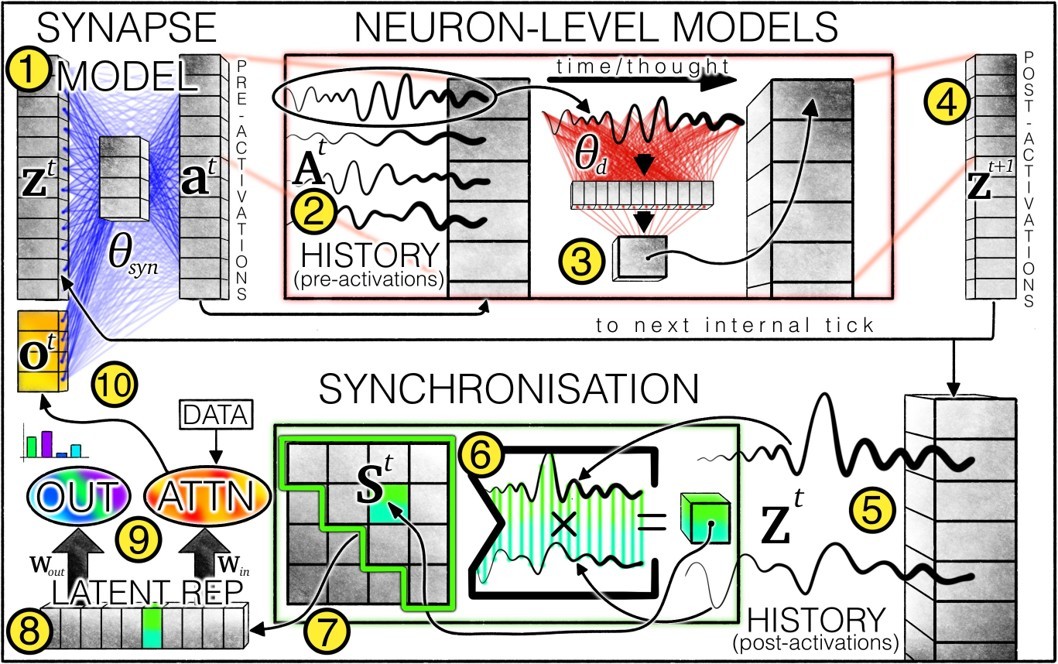

※出典:Sakana AI Continuous Thought Machines「CTMアーキテクチャ」

【図の説明】

①シナプスモデルは、ニューロン間の相互作用をモデル化し、前活性化を生成する。各ニューロンについて、

②事前アクティベーションの履歴は保存され、最新のものが

③ニューロンレベルのモデルを使用して

④アクティベーション。

⑤アクティベーション後の履歴も保存され、

⑥同期行列を計算する。ニューロンペアは

⑦同期マトリックスから選択され、

⑧CTMが持つ潜在的表現

⑨出力を生成し、クロスアテンションを通じてデータを変調する。変調されたデータは

⑩次の内部のポストアクティベーションと連結されます。

この図は、Sakana AI が描いたCTMアーキテクチャの概念図になります。かなり複雑ですが、今までのNNとは全く異なることが分かると思います。

しかし、ここまで難しくなると概念すら理解できませんよ。

申し訳ないですが、私にも全貌を理解できていません。資料を最後に示しますので、もし興味があれば読んでみてください。ただ資料に書いてあることで驚いたフレーズがあります。「データはあらゆるモデリングにとって間違いなく重要ですが、CTM は内部の繰り返しと同期という概念に基づいて設計されており、データの役割は内部プロセス自体に比べてやや二次的なものとなっています」「CTMの内部次元は、神経活動のダイナミクスが展開される領域です。私たちは、このようなダイナミクスが知的思考の礎となる可能性が高いと考えています」現在のAI性能は、学習データに依存すると、ほとんどのAI関係者が考えているので、いかに大量の高品質データを収集できるかを競争しています。ところがSakana AIは、これと異なるアプローチをしているのです。

う~ん。ボクはお勉強が嫌いだから、生成AIみたいに長時間勉強なんかしたことないけど、立派な知性がありますからね。そんなようなもんかな。

たとえがかなりズレていますね。OpenAIも推論時にはアルゴリズムを切り替えています。しかしSakana AIは切り替えるのではなく、知的活動というか思考に対して、もっと本質的なアプローチをしているのです。

そんな気もしますが、結局このCTMはどんな実力があるんですか?

大きな利点は、時間次元を加えたことによって、時間経過とともに問題をどのように解決しているかを、可視化できることです。従来のAIが一回の推論で画像分類するのに対し、CTMは複数のステップを踏みながらタスクの解法について「思考」していることが観察できます。複雑な迷路タスクでは、まるで人間のアプローチのように、試行錯誤しながら遠いゴール地点にも対応ができ、CTMが迷路タスクに対する汎用的な解法を学習できたことを示しました。

なんだ、圧倒的に解決が速いとかじゃないんだ。まだ研究段階だからか。どうも新型AIの開発じゃなくて、人間の思考方法を解明しようと、コンピュータでシミュレーションしているようだな。

その通りです。正確には、入力と出力のみを模倣するシミュレーションではなく、入力と出力の間にある構成要素と機能全てをモデル化するエミュレーションになります。つまりCTM研究は、思考のエミュレーションを目指しているようです。このCTMについては以上になります。ごく最近、またSakana AIから面白い研究成果の発表があったので、次回はそれを説明します。

・Sakana AIの自己適応型 LLM ・Transformer²は、タスクの性質に合わせて重みとアーキテクチャを変更し、継続的な変化と生涯学習が可能なAIである。

・CTMは研究段階だが、ニューロンの強さだけなく、シナプスがスパイクするタイミングまで学習に取り込んだ、まったく新しい人工ニューロンのモデルである。

・CTMは、AIの思考プロセスがエミュレーション可能なので、人間の思考方法が解明できる可能性を秘めた研究である。

(TEXT:谷田部卓 編集:藤冨啓之)

メルマガ登録をしていただくと、記事やイベントなどの最新情報をお届けいたします。

30秒で理解!インフォグラフィックや動画で解説!フォローして『1日1記事』インプットしよう!

データ越境者に寄り添うメデイア「データのじかん」が提供する便利ツールです。

本ツールは、JavaScriptを用いてお客様のブラウザ上で処理を行います。サーバーとの通信は行われず、入力データはお客様のみの端末内で処理されます。

前回に引き続き、Sakana AIのテクノロジーについて紹介します。今回は、前回時間切れで話すことができなかった「自己適応型 LLM」と「時間を使って考えるAI・CTM」になります。

今回も面白そうなタイトルですが、ボクには内容の想像がつきませんね。

まず、2025年1月に発表された「Transformer²(自己適応型 LLM)」になります。この新しいLLMモデルは、与えられたタスクの性質に合わせて重みとアーキテクチャを変更し、継続的な変化と生涯学習が可能な生きた知性を体現する、新世代の適応型 AI モデルと紹介されています。

今回も進化的アルゴリズムを利用しているのですか?

いいえ、今回は違うようです。では、まず概念から説明しましょう。以前LLMの解説をしましたが、LLMは膨大で複雑なニューラルネットワーク(NN)で構成されています。その個々のネットワーク内のパラメータ、つまり重み行列内に知識を蓄積しています。これらの行列内に、トレーニングデータから学習した内容のエッセンスというか、抽出された知識を保持しています。

以前説明してもらった「生成AIの仕組み」の中の特徴量の空間、「潜在空間」と同じことを言ってますよね。

よく覚えていましたね。あの講義ではテックジー先生に解説してもらいました。それでは、自己適応型 LLMの中核部分にある技術・特異値分析SVD(Singular Value Fine-tuning)についての概要を説明します。