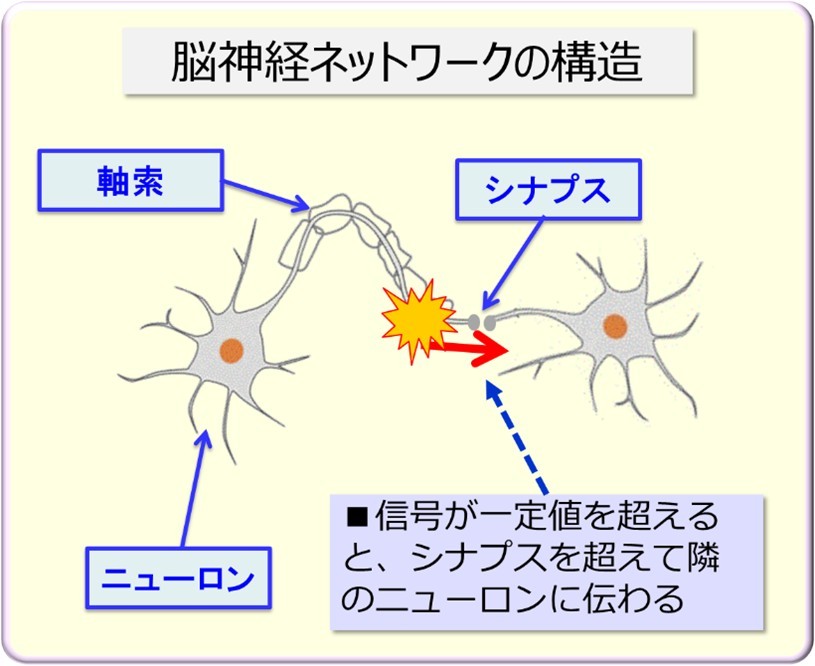

※図版:筆者作成「脳神経ネットワークの構造」

ではさっそく、AIテクノロジーの根幹にある、ニューラルネットワークの説明をします。生物の脳神経ネットワークは、図のように神経細胞・ニューロン同士が、シナプスという接続部分で接続されている構造となっています。シナプスは、隣のニューロンとは物理的には結合しておらず、わずか20~30ナノメートルという極小のスキマがあります。刺激によってニューロン内の電気信号が、閾値を超えて活性化すると、ドーパミンなどの神経伝達物質を用いて、隣のニューロンに信号を伝達していく仕組みになっています。

脳全体を電気信号で伝達させた方が、はるかに速い処理ができると思いますが、なんでわざわざ化学物質を使うんですか?

実はクラゲのような海の生物は、情報のやり取りを、電気シナプスを使って1ミリ秒程度で行っています。しかし高等生物になるほど、化学反応を介することにより200ミリ秒と遅くなっているのです。

だから、どうしてですか?

そこが生物の巧妙なところなのです。電気信号では単純に信号のON・OFFを伝達するだけになってしまいます。しかし単純に伝達するのではなく、ニューロンに何度も刺激が入り、一定の閾値を超えてから隣に信号を伝達するためには、化学物質が必要だったのです。

なるほど。

この巧妙な仕組みによって、脳は記憶や学習が可能になりました。しかもそれだけではなく、眼や耳などから入ってくる一次情報を、後段の脳が記憶や判断などの情報処理するためには、ある程度の時間が必要なので、ディレイをかけているという説もあるのです。

しかし、どうしてその仕組みで、記憶や学習ができるんですか?

産まれた直後は未接続だった神経回路内のニューロン同士が、互いに結合したとき、すなわちシナプスを増強したときに、記憶となります。短期記憶の場合、この作用は数分から数時間だけ維持しますが、長期記憶になるとシナプスの増強が恒久化するようです。重要なことが何度も生じると、ニューロンの電気信号が繰り返し強く発火することで、記憶が強化されるようですね。

ようだ、とか話だ、ばかりで急に歯切れが悪くなりましたよ。先生。

まあそうですね、近年、脳科学は急速に発達して、大量の知見や情報が蓄積されてきました。それでも生きている脳をリアルタイムで観測する手段がまだ確立していないので、仮説ばかりなのです。また、ニューロンは脳に千数百億もあり、そのネットワークの全容は未だに解明されていません。ですから仕方がないのです。

自分の臓器のことなのに、分からないことだらけなんだなぁ

とにかくですね、AIの基本構造である、ニューラルネットワークとは、このニューロンというか、脳神経ネットワークを真似して作られたものなのです。

えーと、コンピュータつまり計算機は、その名の通り最初から計算する道具として、2進法をベースに設計されていますよね。このニューラルネットワークは、脳をモデルにしているのは分かりましたが、初めは何を目的として、何ができるように、設計したんですか?

いやぁ、鋭いですね。コンピュータは、確かに最初から高速に計算することを目的として、設計されています。1943年にアメリカのマカロックとピッツが、共著で発表した論文「神経活動に内在する思考の論理計算」で、ニューロンは論理ユニットであり、そのユニットで構成されるネットワークは、どんな計算でも実行できるように構築可能だと示しました。これを手掛かりにして、ニューラルネットワークは、学習する機械の実現を目指していた研究者たちによって、研究対象として作られたのです。それでは次に、このニューラルネットワークの初期の研究の歴史を話すことにしましょう。

プレスリーが聴衆を熱狂させていた1956年、アメリカのダートマス大学で、初めての人工知能会議が開催された。「ダートマス会議」という、人工知能分野では著名な会議だ。ここには、情報理論の生みの親であるクロード・シャノンや、人工知能の父と称されたマービン・ミンスキーなど、当時の人工知能研究者が一堂に会し、6週間にもわたるワークショップだった。そこでいくつかの知能モデルが、提案や検討がされたが、実際にそれを実証できるマシンは、まだ存在していなかった。

その頃、コーネル大学のローゼンブラットは、ニューラルネットワークをパーセプトロンと呼び、人間の学習、記憶、認識の効果的モデルとして機能することを、証明しようと研究していた。ローゼンブラットは、眼の網膜に着目して、視神経をモデルにしたネットワークを考えた。当時、神経の成長はランダムで繰り返されることで神経連結が強化され、そうでない神経連結は弱められることで、学習が進むと考えられていたのだ。したがって、網膜のように光電管を多数並べて、神経にあたる接続を最初はランダムにし、学習結果を見ながら配線を調整するような視神経のモデルをつくれば、形を見わけることができるはずとローゼンブラットは考えた。

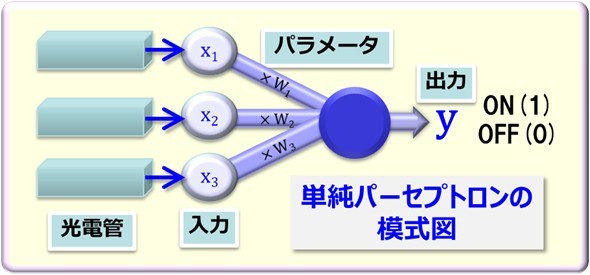

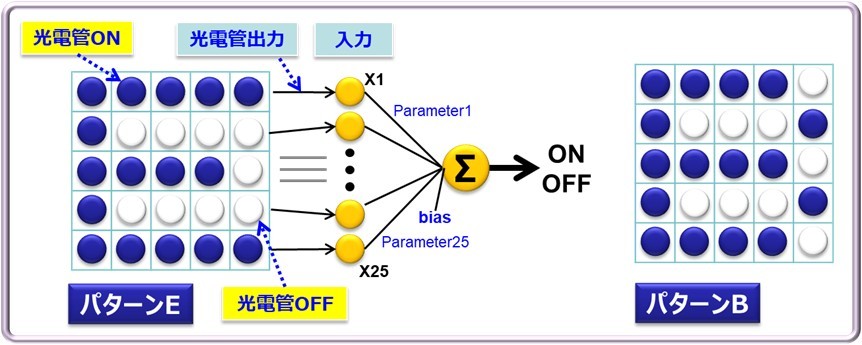

※図版:筆者作成「単純パーセプトロンの模式図」

この、アナログ回路で構成された単純パーセプトロンは、光電管にパターンAを与えて、その出力信号をパーセプトロンの入力とした。各信号のパラメーターを調整して出力を「1」とする。パターンAと異なるパターンの場合は、「0」が出力するようにパラメーターを更新して、入力パターンの区別ができるようにしたのだ。この方式で単純な図形やアルファベットなら学習することができるようになった。

先生、説明が雑すぎて分かりません。

※図版:筆者作成「単純パーセプトロンの動作原理」

そうですか。一般的なニューラルネットワークの説明では、この単純パーセプトロンの数式を示しておしまいなのですが。仕方がないので、この模式図を使いましょう。縦横5本ずつ、25本の光電管つまり光センサーを並べてパーセプトロンの入力とします。この光電管は光があたると、電流が流れます。これなら、たてよこ5ドットあるので、単純な数字やアルファベットを区別ができそうですね。

そうですね。

この光電管のON/OFF信号を全部足した電流値だけでは、アルファベットのEとアルファベットBのように、ONの数が同じだと区別がつきません。しかしこの25個の入力に、それぞれ別の値つまりパラメーターがあると、AとEでは出力値が異なるので、区別ができるようになります。あらかじめ取得しておいたパターンEの正解値と出力値を最後に比較すれば、その入力がパターンEかどうかを判定できることになります。

まぁ、少なくとも単純なアルファベットや数字程度なら、光電管を並べた電気回路だけで区別ができることがイメージできますね。でもそれって、学習なんですか?

最初は各光電管のパラメーターは分かりませんが、区別ができるようにパラメーターを人が調整していきます。最終的にすべて区別が出来たら、その光電管の回路、つまりパーセプトロンは「アルファベットや数字の学習ができた」ということになりますね。

うーん、まあそうと言ってもいいのかな。

その後、ローゼンブラットは、大規模なパーセプトロンを開発することで、複雑な図形も学習できるようになると主張しました。するとこの研究結果を、サイエンス誌が「人間の脳を取り換える?」というセンセーショナルなタイトルで取り上げ、パーセプトロンの記事を掲載したのです。この記事によってローゼンブラットは一躍脚光を浴び、これがきっかけで最初の人工知能ブームとなったのです。

じゃあ、その頃からマシンが学習できていたんだ。それは凄いことだな。でもそんな凄いマシンなら、どんどん進化していったんですか?

ところが、当時の人工知能の権威であるミンスキー教授は、単純パーセプトロンをいくら追及しても、すぐに限界がくると厳しく批判したのです。

なんでですか?素晴らしい研究なら一緒に共同研究すればいいのに。

当時のアメリカの大学の研究室は、権威がものを言う社会で、研究予算も常に取り合っていたのです。人気のパーセプトロンに多額の研究費を取られると、それまで主流派だった論理学をベースにしたミンスキー教授たちの研究費は、減らされてしまったのです。この争いは、その後10年もの間、続くことになります。

ではその決着は、どうなったんですか?

1969年にミンスキーは、単純パーセプトロンが線形分離可能な問題しか学習できないことを、反論の余地がないほど数学的に証明したのです。世の中の問題の大半は線形分離不可能な問題だったため、パーセプトロンへの研究資金は一夜で消えてしまい、ニューラルネットワークは、その後10年以上の冬の時代に突入することになります。

えー、そうなんだ。でも、線形分離可能な問題しか学習できない、ってどんな意味ですか?

サルくん、そもそも学習するとは、どんな意味だと考えていますか?

え~とですね、勉強して問題とその答えを、覚えることかなー?

それは丸暗記と言います。

まあそうだな。丸暗記だと応用問題ができないか。似たような問題まで、できるようになったら、学習できたと言っていいのかなー。そうだ。問題に共通するパターンを見つけて、応用できたら学習できたことになるんだ。

だいたいそんなところです。このコンピュータの世界というか、機械学習や深層学習では、学習や認識という言葉は、正しく分類できる、という意味で使う場合が多いのです。

えー!意味分からないですよ!

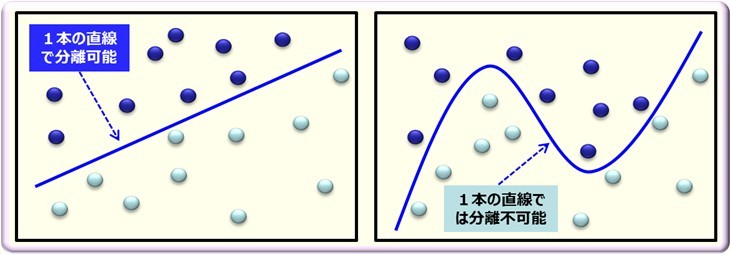

※図版:筆者作成「線形分離」

では分かりやすい二値分類問題で説明しましょう。たとえばですね、机の上にたくさんの青い丸と白い丸の紙が、分かれておいてあったとします。そして、この青い丸の紙と白い紙の集まりの間に、境界線を引くと、分離できますね。

そりゃ、子どもでもできますよ。

で、その境界線が単純な直線で分離できたら、線形分離ができる、と言います。

そうですか。

そして、その境界線が、複雑な曲線でないと分離できない場合を、線形分離不可能、と呼びます。つまり単純な特徴だけで分離できないものが、線形分離不可能です。

なるほど、そうなんですか。それで?

猫の写真をたくさん見ることで、猫を犬とか他の動物から見分けることができますね。猫を正しいカテゴリーに分類できることで、猫を認識できたとか、猫を学習できた、というのです。

そうか。つまり画像認識とは、正しく分類することだったんだ。やっとわかったぞ。世の中のほとんどのことは、それほど単純に分けられないので、単純パーセプトロンは見放されたのか。

しかも、この話には続きがあります。ローゼンブラットはパーセプトロンが抹殺されてから、すぐにボートの事故で亡くなってしまったのです。これも悲劇的な話ですね。今回のパーセプトロンの説明は、これで終わりにします。

図版・書き手:谷田部卓

AI講師、サイエンスライター、CGアーティスト、主な著書に、MdN社「アフターコロナのITソリューション」「これからのAIビジネス」、日経メディカル「医療AI概論」他、複数の美術展での入賞実績がある。

(図版・TEXT:谷田部卓 編集:藤冨啓之)

メルマガ登録をしていただくと、記事やイベントなどの最新情報をお届けいたします。

30秒で理解!インフォグラフィックや動画で解説!フォローして『1日1記事』インプットしよう!

データ越境者に寄り添うメデイア「データのじかん」が提供する便利ツールです。

本ツールは、JavaScriptを用いてお客様のブラウザ上で処理を行います。サーバーとの通信は行われず、入力データはお客様のみの端末内で処理されます。

前回までは、人工知能の概念を作った、チューリングのお話でした。今回からは、人工知能の基本構造を担っている、ニューラルネットワークの説明をしましょう。

前回のチューリング物語は、とても面白かったので期待してます。