「OK Google、プレゼント用のオリジナル曲を作ってよ。」

なんてCMの中で言われる日は来るでしょうか?

最近、職業作曲家の方と話すと「自分たちの仕事はいつAIに乗っ取られるんだろう?」なんて冗談交じりに尋ねてきたりします。しかし、実際そんなことを言っておきながら、その現状とどう付き合うか、果たして今AIでどれくらいのことができるのか?っていうこと自体、プロの作曲家達にしてもまだあんまりピンと来てないのが現状です。実際、私自身も作曲家の一人でもありますし、他人事ではありません。

現代音楽におけるアルゴリズムを使った音楽も自動作曲と言えますし、東大で開発されているオルフェウスやカリフォルニア大学サンタクルーズ校の音楽家・研究者である David Cope によるバッハをはじめとした作曲家の模倣を行うEmmy(またはEMI、Experiments in Musical Intelligenceの略、実際の音源は上の動画を再生)や、Sony Computer ScienceのFlow Machines(実際の音源は、下の動画を再生。下の動画は株式会社ライトトラックス 菊地智敦氏がFlow Machineを使って制作し、AIが作ったメロディーラインを人間の音楽家がプロデュース、アレンジしています)などなど、たくさんの試みがあります。

幸か不幸か現在(2018年時点)ではまだ、人間の仕事を置き換えるということにはなっていません。しかし、実際には「作曲」以外の音楽制作の分野に目を向けてみるとAIはものすごい勢いで実用化されています。例えば、マスタリング、トラックダウンといった音楽制作の工程はかなりAIと相性が良く、iZOTOPE neutronやLANDRといったツールなどが実際にすでに使用されています。

これらは音楽エンジニアやアレンジャーの仕事をすでに一部置き換え始めています。また実際作業工程を省く便利なツール、として利用されている現場の方々も多いでしょう。

さて、それに対して作曲はどうでしょう。ここでは実際に「ユーザー自身が作曲ができる」サービスをいくつか試して、考えてみましょう。

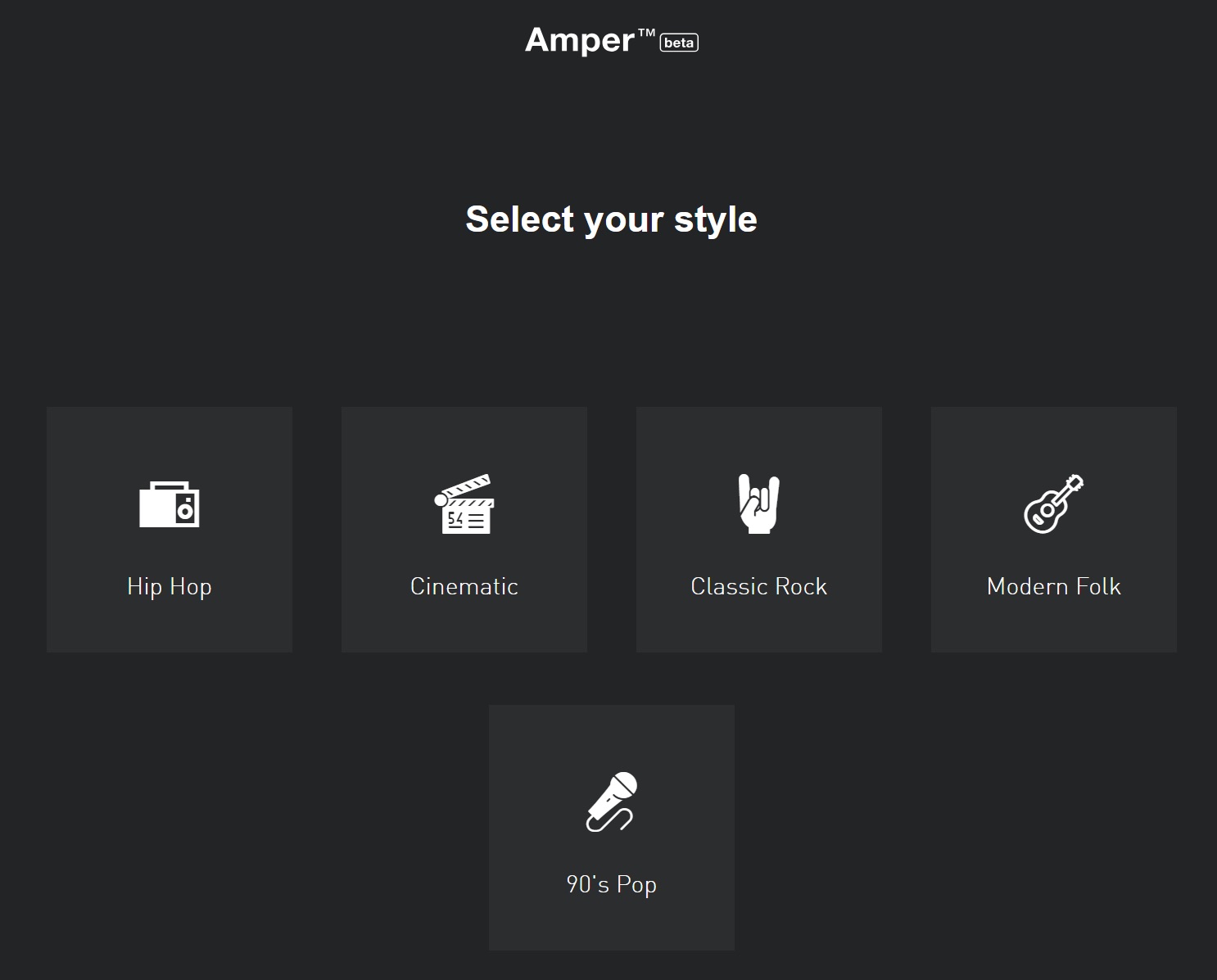

まず最初にご紹介するのは世界初のAI作曲サービスとしてサービスインして話題になったAmper Music。(2018年10月25日で一旦β版のサービスは停止となっています。)

アプリ・音楽・メディア制作を行う株式会社バイラルワークス代表。

東京大学大学院学際情報学府修士課程。自身も音楽プロデューサー、作曲家としての顔を持つ。アーティスト活動に加え、ドラマ主題歌、ゲームなどヒット作多数。現在は仕事をしながら1〜2カ月ごとに国を移り、十数カ国を渡り歩く「移住生活」を行っている。

メルマガ登録をしていただくと、記事やイベントなどの最新情報をお届けいたします。

30秒で理解!インフォグラフィックや動画で解説!フォローして『1日1記事』インプットしよう!

データ越境者に寄り添うメデイア「データのじかん」が提供する便利ツールです。

本ツールは、JavaScriptを用いてお客様のブラウザ上で処理を行います。サーバーとの通信は行われず、入力データはお客様のみの端末内で処理されます。